| Points clés | Détails à retenir |

|---|---|

| 🤖 Définition | En 2025, le machine learning repose sur des systèmes capables d’auto-amélioration continue. |

| 📊 Données | Volume et qualité guident la performance des modèles et la robustesse des prédictions. |

| ⚙️ Algorithmes | AutoML et réseaux de neurones hybrides dominent les pipelines de production. |

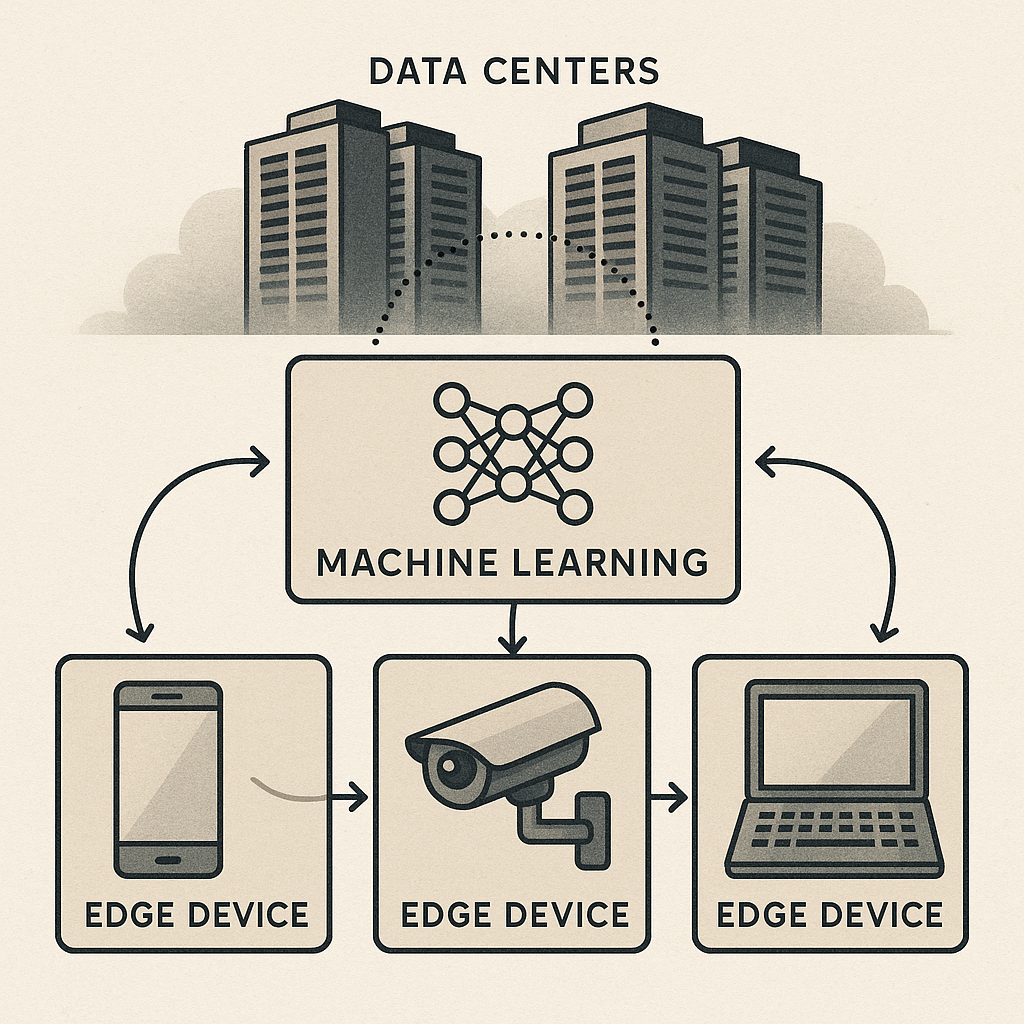

| 🌐 Architecture | Edge AI et calcul distribué réduisent la latence et améliorent la confidentialité. |

| 💡 Applications | Santé, industrie, mobilité adoptent massivement ces innovations. |

| ⚖️ Éthique | Transparence et lutte contre les biais sont au cœur des débats. |

Le machine learning en 2025 n’a plus grand-chose à voir avec les prototypes d’il y a dix ans. Aujourd’hui, on parle de systèmes quasiment autonomes, capables d’ajuster leurs propres paramètres, de se déployer en périphérie du réseau (Edge AI) et même de proposer des pipelines complets sans intervention humaine. Cet article explore les fondements techniques, les architectures émergentes et les enjeux éthiques qui façonnent cette nouvelle ère.

Les piliers du machine learning en 2025

Pour comprendre l’essor actuel, il faut revenir aux fondamentaux : données, algorithmes et infrastructures. Leur synergie a évolué dans un contexte où la puissance de calcul, le stockage distribué et l’accès à des bases colossales redéfinissent les possibles.

En parallèle, les exigences de robustesse et de transparence poussent à revoir chaque composant du pipeline, de l’ingestion des jeux de données à l’interprétabilité des résultats.

Données massives et qualité

On pourrait croire que plus on a de données, mieux c’est. En réalité, l’enjeu principal en 2025 est la qualité et la représentativité. Des études récentes montrent que des données faiblement étiquetées ou biaisées conduisent à des modèles moins fiables, parfois catastrophiques dans des contextes sensibles comme la santé.

- Nettoyage automatisé : des outils d’IA détectent et corrigent les anomalies sans intervention humaine.

- Gain de temps : les pipelines de prétraitement peuvent réduire jusqu’à 70 % le temps consacré à l’étiquetage.

- Échantillonnage dynamique : certaines plateformes adaptent la composition des données en temps réel pour éviter les dérives statistiques.

Algorithmes auto-adaptatifs

Exit les entraînements statiques : la tendance est aux modèles « self-learning ». Ils mettent en place des boucles de rétroaction continues, s’ajustant dès qu’un nouveau lot de données arrive. Cette approche minimise l’obsolescence et réduit la nécessité de réentraîner manuellement.

Concrètement, un réseau de neurones hybride peut modifier son architecture en fonction de la complexité des tâches, en augmentant ou en simplifiant ses couches selon le contexte opérationnel.

Les architectures et outils émergents

Après les bases, penchons-nous sur l’infrastructure. Les progrès en matière de hardware et de logiciels créent un terreau fertile pour déployer des systèmes ML à grande échelle, tout en maîtrisant les coûts et la sécurité.

Edge AI et calcul distribué

Plutôt que de tout centraliser dans le cloud, de plus en plus d’entreprises déploient leurs modèles à la périphérie du réseau. L’Edge AI offre plusieurs avantages :

- Réduction de la latence : les décisions sont prises en millisecondes, indispensables pour la robotique ou les véhicules autonomes.

- Confidentialité renforcée : les données sensibles (santé, finance) restent sur site.

- Évolutivité : des milliers de capteurs IoT peuvent héberger de petits modèles ML sans saturer le réseau global.

Cette architecture distribue la charge et optimise les ressources, tout en répondant aux exigences réglementaires sur la localisation des données.

AutoML et pipelines autonomes

Le rêve de tout data scientist ? Un outil capable de tester automatiquement plusieurs algorithmes, de sélectionner les hyperparamètres et de déployer le meilleur modèle, sans intervention humaine. En 2025, c’est devenu presque banal.

« L’AutoML a démocratisé l’accès au ML : les équipes métier peuvent produire des prototypes en quelques heures au lieu de plusieurs semaines. » Dr. Clara Dupont, experte en IA.

Cerise sur le gâteau, certains frameworks intègrent déjà des gardes-fous éthiques, vérifiant que la solution ne tombe pas dans des cas de discrimination.

Applications concrètes et défis éthiques

Que ce soit dans la santé, la logistique ou la finance, les cas d’usage se multiplient. On assiste par exemple à :

- Analyse prédictive en médecine : repérage de signes précoces de maladies neurodégénératives.

- Maintenance prédictive dans l’industrie : réduction des arrêts machines jusqu’à 40 %.

- Optimisation des réseaux de distribution d’énergie : ajustement fin en temps réel pour absorber les pics de demande.

Toutefois, ces avancées soulèvent des questions :

- Comment garantir la transparence des décisions prises par un modèle ?

- Quels mécanismes mettre en place pour contrecarrer les biais historiques ?

- Peut-on concilier performance et respect de la vie privée ?

Perspectives et innovations à surveiller

En 2025, on garde un œil sur plusieurs tendances émergentes :

- Modèles multimodaux : fusion de texte, image et son pour une compréhension plus riche.

- Apprentissage fédéré : entraînement collaboratif sans partager les données brutes.

- IA générative supervisée : création de contenus tout en respectant des lignes directrices éthiques.

À mesure que ces technologies mûrissent, l’enjeu sera de trouver le bon équilibre entre innovation rapide et garde-fous pour éviter les dérives.

FAQ

Qu’est-ce qui différencie le machine learning de 2025 de celui d’il y a dix ans ?

Les modèles sont aujourd’hui capables d’auto-ajustement, d’« apprentissage continu » et de déploiement à la périphérie. Les infrastructures sont plus modulaires et intègrent des mécanismes éthiques en natif.

Le AutoML va-t-il remplacer les data scientists ?

Plutôt que de disparaître, leur rôle évolue : ils deviennent superviseurs, éthiciens et stratèges, tandis que les tâches répétitives sont automatisées.

Quels secteurs bénéficient le plus de l’Edge AI ?

La santé, l’industrie 4.0 et les transports autonomes sont en tête, car ils exigent des décisions en temps réel et une protection stricte des données.

Comment lutter contre les biais dans les modèles ML ?

En diversifiant les jeux de données, en utilisant des audits réguliers et en intégrant des garde-fous algorithmique au sein des pipelines AutoML.